新的大谈话模子(LLM)评估基准对于跟上大谈话模子的快速发展至关蹙迫开云体育。

近日,淘宝天猫集团的有计划者们提倡了华文苟简问答(Chinese SimpleQA),这是首个全面的华文基准,具有"华文、各样性、高质地、静态、易于评估"五个脾气,用于评估谈话模子回答苟简问题的确凿性才气。

有计划东说念主员示意,华文苟简问答大概指诱掖诱者更好地剖释其模子的华文确凿性才气,并促进基础模子的发展。

论文地址:https://arxiv.org/abs/2411.07140

小序

东说念主工智能发展中的一个紧要挑战是确保谈话模子生成的回答在事实上准确无误。面前前沿模子偶然会产生罪恶输出或衰退根据解救的谜底,这即是所谓的"幻觉"问题,极地面辞谢了通用东说念主工智能技巧(如大谈话模子)的广博诓骗。此外,评估现存大谈话模子的确凿性才气也颇具难度。举例,大谈话模子频繁会生成冗长的回答,包含大量事实性施展。最近,为处分上述评估问题,OpenAI 发布了苟简问答基准(SimpleQA),其中包含 4326 个简约且寻求事实的问题,使得揣测确凿性变得约略可靠。

但是,苟简问答基准主要针对英语,导致对大谈话模子在其他谈话中的才气了解有限。此外,受近期几个华文大谈话模子基准(如 C-Eval、CMMLU)的启发,为了评估大谈话模子在华文语境下的确凿性才气,淘天集团的有计划东说念主员提倡了华文苟简问答基准。该基准由 3000 个高质地问题构成,涵盖从东说念主文到科学工程等 6 个主要主题。具体而言,华文苟简问答的显贵主要特征如下:

华文脾气:专注于华文谈话,大概全面评估现存大谈话模子在华文语境下的确凿性才气。

各样性:涵盖 6 个主题,即"中国文化""东说念主文""工程、技巧与诓骗科学""生存、艺术与文化""社会"和"当然科学"。这些主题总计包括 99 个细粒度的子主题,体现了华文苟简问答的各样性。

高质地:实施了全面且严格的质地适度历程,以确保华文苟简问答的质地和准确性。

静态性:与 SimpleQA 近似,为保握华文苟简问答的常青脾气,整个参考谜底不会随时分改动。

易于评估:与 SimpleQA 近似,由于问题和谜底都十分苟简,通过现存大谈话模子(如 OpenAI API)进行评分的过程快速简单。

有计划东说念主员在华文苟简问答上对现存大谈话模子进行了全面评估和分析,得出了以下一些有瞻念察力的发现:

华文苟简问答具有挑战性:惟有 o1-preview 和 Doubao-pro-32k 达到合格分数(在正确磋商上分辩为 63.8% 和 61.9%),很多闭源和开源大谈话模子仍有很大的改良空间。

模子越大效劳越好:基于 Qwen2.5 系列、InternLM 系列、Yi-1.5 系列等的末端,作家不雅察到模子越大性能越好。

更大的模子更校准:作家不雅察到 o1-preview 比 o1-mini 更校准,GPT-4o 比 GPT-4o-mini 更校准。

检索增强生成(RAG)很蹙迫:当将 RAG 政策引入现存大谈话模子时,不同大谈话模子之间的性能差距显贵缓慢。举例,对于 GPT-4o 和 Qwen2.5-3B,使用 RAG 后性能差距从 42.4% 缓慢到 9.3%。

存在对都代价:现存的对都或后考研政策频繁会裁汰谈话模子的确凿性。

SimpleQA 和华文苟简问答的名次不同:几个专注于华文的大谈话模子(Doubao-pro-32k 和 GLM-4-Plus)的性能接近高性能的 o1-preview。出奇是在"中国文化"主题上,这些华文社区大谈话模子明显优于 GPT 或 o1 系列模子。

华文苟简问答详尽

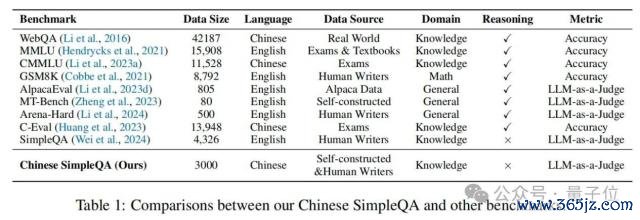

华文苟简问答的类别散布,包含六个主要主题,每个主要主题包含多个二级子主题。在表 1 中,作家将华文苟简问答与几个主流的大谈话模子评估基准进行了比较,这标明华文苟简问答是第一个专注于评估大谈话模子中华文知识界限的基准。

数据网罗

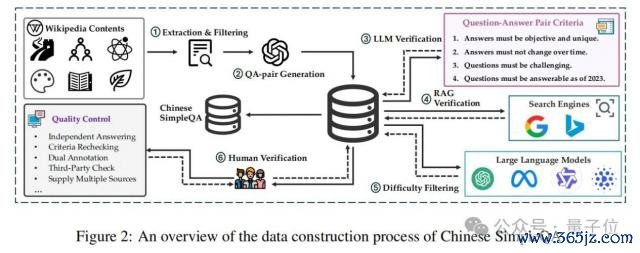

如图 2 所示,华文苟简问答的数据网罗过程触及自动构建和东说念主工考据。自动阶段包括:(1)索取和过滤研讨知识内容,(2)自动生成问题 - 谜底对,(3)根据预界说轨范使用大谈话模子考据这些对,(4)实施检索增强生成(RAG)考据,以及(5)进行难度筛选。

具体而言,源泉,作家从各样知识限制(如维基百科)网罗大量知识丰富的文本内容,并使用质地评估模子过滤掉低质地数据。然后,作家教导大谈话模子使用这些高质地知识内容生成问题 - 谜底对。之后,为确保华文苟简问答的质地,作家使用大谈话模子去除不相宜预界说轨范条目的样本。通过这种姿色,不错得到大量初步筛选后的知识问题 - 谜底对。同期,为了提升谜底的质地,部署外部检索器具(即搜索引擎)来网罗更各样化的信息,这教诲大谈话模子基于 RAG 系统评估谜底的事实正确性。具体来说,诓骗 LlamaIndex 行动检索次序,以谷歌和必应的搜索末端行动数据源。对于生成和考据的醒目信息不错在附录 A 中找到。此外,作家过滤一些约略样本以发现大谈话模子的知识界限并提升华文苟简问答的难度。具体来说,要是一个问题不错被四个大模子正确回答,则合计它是一个约略问题并将其丢弃。

值得在意的是,问题 - 谜底对的构建基于以下轨范:

谜底必须客不雅且惟一:问题应与客不雅宇宙的事实知识研讨,不受个东说念主主不雅不雅点影响。举例,以"你合计……何如样?"或"你怎样评价……?"源泉的问题是分歧适的。此外,每个问题的谜底必须是惟一的,摒除多个正确谜底的可能性。举例,"朱祁镇在哪一年登上皇位?"这个问题是不充分的,因为它有两个可能的谜底:1435 年和 1457 年。

谜底必须不随时分变化:谜底应永久响应不灭的事实,不受发问时分的影响。举例,"碳的原子序数是若干?",谜底" 6 "永久不变。比较之下,对于局势的问题,如"某个国度的现任总统是谁?"是分歧适的,因为其谜底会随时分变化。

问题必须具有挑战性:问题不应过于约略,遐想的查询需要全面评估模子的知识深度。

问题必须限定 2023 年可回答:每个问题必须在 2023 年 12 月 31 日前可回答,以确保对在此日历后考研的数据的模子进行平正评估。

2.3 质地适度

在自动数据网罗之后,遴荐东说念主工考据来提升数据集质地。具体来说,每个问题由两个东说念主工疑望者孤苦评估。源泉,疑望者详情问题是否相宜上述预界说轨范。要是任何一个疑望者合计问题不相宜条目,则丢弃该样本。随后,两个疑望者都使用搜索引擎检索研讨信息并制定谜底。在此阶段,疑望者应使用泰斗来源(如维基百科、百度百科)的内容,况兼每个疑望者必须提供至少两个解救性 URL。要是疑望者的谜底不一致,则由第三个疑望者审查该样本。最终疑望由第三个疑望者根据前两个评估详情。终末,将东说念主工疑望末端与大谈话模子生成的回答进行比较,仅保留都备一致的问题 - 谜底对。这个严格的东说念主工考据过程确保了数据集保握高准确性并相宜既定轨范。

在构建和疑望华文苟简问答的通盘过程中,很多低质地的问题 - 谜底对被丢弃。具体来说,当先生成了 10000 对。经过使用不同模子进行难度评估后,大致保留了 6310 对,其中约 37% 的较约略数据被丢弃。在此之后,经过基于章程的考据和基于模子的 RAG 考据,又删除了 2840 个样本,这意味着仅剩下约 35% 的原始生成数据。终末,经过透澈和严格的东说念主工审查,仅保留了约 3000 个样本,约占原始数据集的 30%。

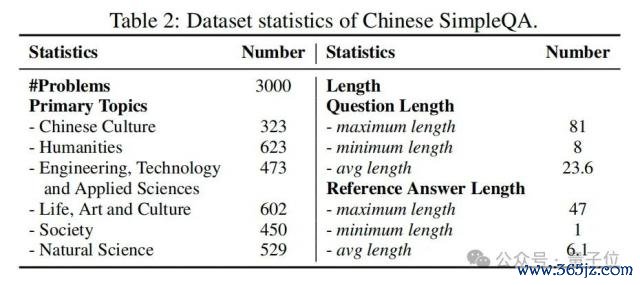

2.4 数据集统计

表 2 展示了华文苟简问答的统计数据。共有 3000 个样本,华文苟简问答在六个主要主题上的数据散布相对平衡,这不错有用地评估大谈话模子在各个限制的知识界限。此外,该数据鸠合问题和参考谜底的长度散布都十分短,这是基于知识查询的特色。值得在意的是,使用华文苟简问答评估模子需要最少的输入和输出标志,从而导致十分低的评估磋商和时分老本。

2.5 评意想议

与 SimpleQA 近似,华文苟简问答也遴荐以下五个评意想议:

正确(CO):预计谜底都备包含参考谜底,且不引入任何矛盾元素。

未始试(NA):预计谜底未都备给出参考谜底,但与参考谜底不存在矛盾元素。

不正确(IN):预计谜底与参考谜底矛盾,即使矛盾不错处分。

尝试后正确(CGA):该磋商是在尝试回答的问题中准确回答问题的比例。

F 分数:该磋商示意正确和尝试后正确之间的调处平均值。

3. 执行 3.1 基线模子

作家评估了 17 个闭源大谈话模子(即 o1-preview、Doubao-pro-32k、GLM-4-Plus、GPT-4o、Qwen-Max、Gemini-1.5-pro、DeepSeek-V2.5、Claude-3.5-Sonnet、Yi-Large、moonshot-v1-8k、GPT-4-turbo、GPT-4、Baichuan3-turbo、o1-mini、Doubao-lite-4k、GPT-4o-mini、GPT-3.5)和 24 个开源大谈话模子(即 Qwen2.5 系列、InternLM2.5 系列、Yi-1.5 系列、LLaMA3 系列、DeepSeek 系列、Baichuan2 系列、Mistral 系列、ChatGLM3 和 GLM-4)。

3.2 主要末端

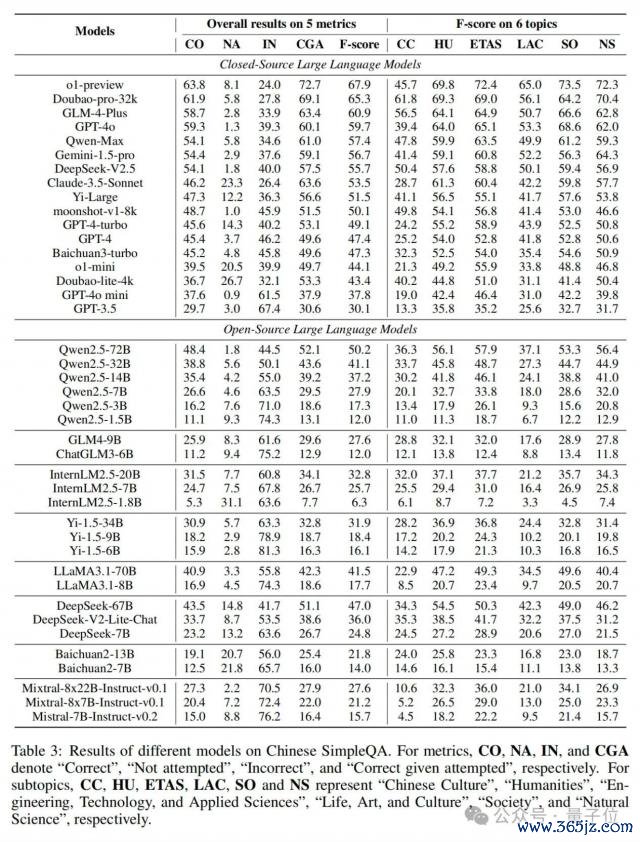

如表 3 所示,论文提供了不同大谈话模子在华文苟简问答上的性能末端。具体来说,与 SimpleQA 近似,作家提供了五个评意想议的总体末端。

此外,论文还答复了六个主题的 F 分数,以分析这些大谈话模子的细粒度确凿性才气。在表 3 中,有以下有瞻念察力和意旨的不雅察末端:

o1-preview 发扬最好:o1-preview 在华文苟简问答上取得了最好性能,况兼几个近期专注于华文的闭源大谈话模子(Doubao-pro-32k 和 GLM-4-Plus)的性能末端与 o1-preview 十分接近。

" mini "系列模子发扬较差:很明显," mini "系列模子(o1-mini、GPT-4o-mini)的末端比相应的更大模子(o1-preview、GPT-4o)低,这也标明这些" mini "系列模子不堤防系念事实性知识。

模子越大性能越好:基于很多模子系列(如 GPT、Qwen2.5、InternLM2.5、Yi-1.5),咱们不错得出更大的大谈话模子会导致更好的性能这一论断。

小模子在"未始试"上得分较高:袖珍大谈话模子频繁在"未始试(NA)"上得分较高。o1-mini、InternLM2.5-1.8B 的 NA 分数分辩为 20.5 和 9.3,远高于相应更大模子的分数(o1-preview 为 8.1,Qwen2.5-72B 为 1.8)。

不同子主题性能互异显贵:不同大谈话模子在不同子主题上存在显贵的性能互异。值得在意的是,华文社区大谈话模子(如 Doubao-pro-32k、GLM-4-Plus、Qwen-Max、Deepseek)在"中国文化(CC)"子主题上明显优于 GPT 或 o1 模子。比较之下,o1 在与科学研讨的子主题(如"工程、技巧与诓骗科学(ETAS)"和"当然科学(NS)")上具有显贵上风。

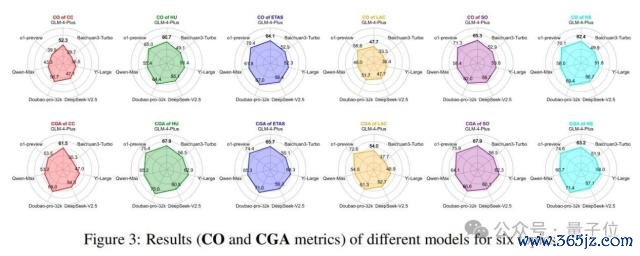

此外,论文还在图 3 中提供了六个主题的醒目末端(CO 和 CGA 磋商)。

3.3 进一步分析

3.3.1 校准分析

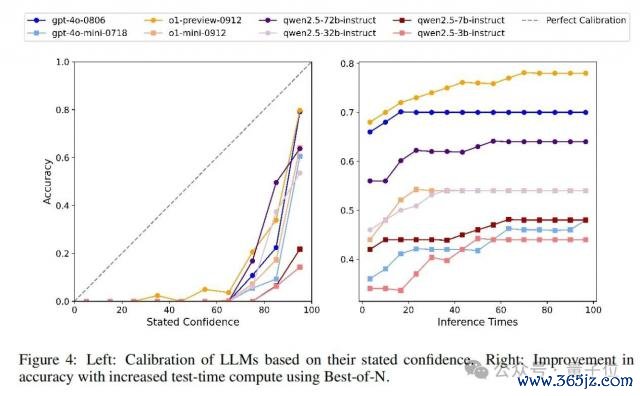

对于不同大谈话模子的校准,与 SimpleQA 近似,作家指令模子在回答问题时提供相应的置信水平(从 0 到 100),以揣测模子对其谜底的信心(见附录 B 中的教导)。咱们知说念,一个无缺校准的模子的置信度(%)应该与其谜底的本体准确性相匹配。图 4 中的左图说明了校准性能,这标明 GPT-4o 比 GPT-4o-mini 校准得更好,o1-preview 比 o1-mini 校准得更好。对于 Qwen2.5 系列,校准轨则为 Qwen2.5-72B>Qwen2.5-32B>Qwen2.5-7B>Qwen2.5-3B,这标明更大的模子尺寸会导致更好的校准。此外,对于整个评估模子,它们在置信度>50 的范围内的置信度低于无缺校准线,这意味着它们都高估了其回答的准确性,存在过度自信的情况。

3.3.2 测试时分磋商分析

论文还评估了不同模子在增多测试时分磋商时与回答准确性的联系。具体来说,从华文苟简问答中立时抽取 50 个样本,对于每个样本,模子被条目孤苦回答 100 次。然后,使用最好 N 法跟着推理次数的增多得到模子的回答准确性。末端如图 4 中的右图所示。作家不雅察到,跟着推理次数的增多,整个模子的回答准确性都有所提升,并最终达到一个上限。这对于华文苟简问答来说是合理的,因为它很是用于探伤模子知识的界限。

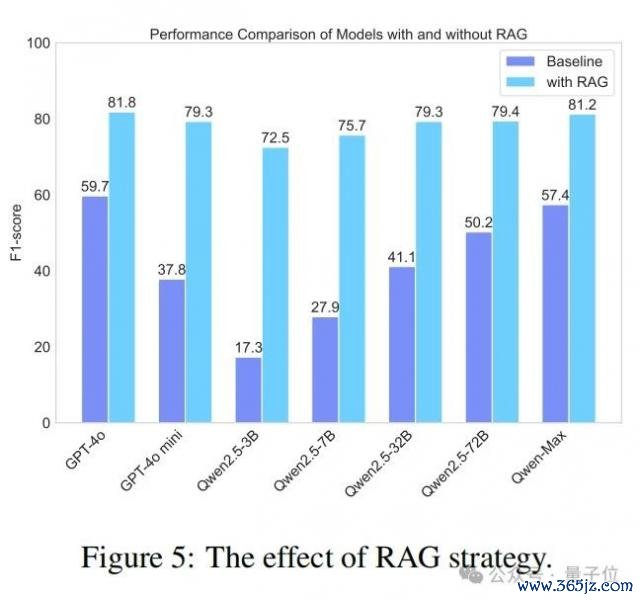

3.3.3 检索增强生成(RAG)效劳分析

在这项有计划中,论文探索了检索增强生成(RAG)政策在提广漠谈话模子在华文苟简问答数据集上的事实准确性方面的有用性。具体来说,作家基于 LlamaIndex 重现了一个 RAG 系统,并整合了谷歌搜索 API。如图 5 所示,整个模子在使用 RAG 后准确性都有显贵提升。举例,Qwen2.5-3B 的性能提升了三倍多。值得在意的是,简直整个使用 RAG 的模子都优于原生的 GPT-4o 模子。同期,RAG 的诓骗也显贵裁汰了模子之间的性能差距。举例,使用 RAG 的 Qwen2.5-3B 与使用 RAG 的 Qwen2.5-72B 之间的 F 分数互异仅为 6.9%。这标明 RAG 大大缓慢了模子之间的性能差距,使较小的模子在使用 RAG 增强时也能罢了高性能。总体而言,这标明 RAG 是提广漠谈话模子确凿性的有用捷径。

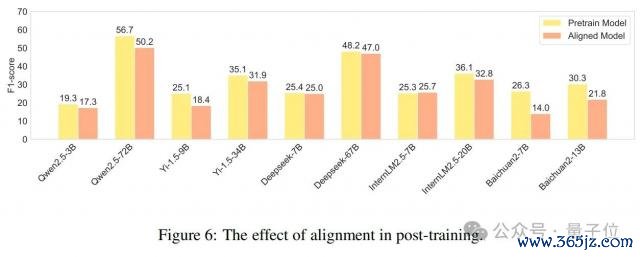

3.3.4 对都代价分析

最近,先前的有计划(OpenAI,2023;Song 等东说念主,2023)发现,对都可能会导致谈话模子才气的下落,即所谓的"对都代价"。为了说明对都对确凿性的影响,作家对预考研模子和经过监督微调(SFT)或强化学习从东说念主类反馈(RLHF)考研的对都模子进行了比较性能分析。如图 6 所示,不同模子在考研后发扬出不同的趋势,但大多数模子都有显贵下落。其中,Baichuan2 系列模子下落最为显贵,Baichuan2-7B 和 Baichuan2-13B 的 F 分数分辩裁汰了 47% 和 28%。这响应出面前大多数大谈话模子的对都考研在产生知识幻觉方面仍然存在明显劣势,这进一步响应了这次数据集的必要性。

3.3.5 子主题末端分析

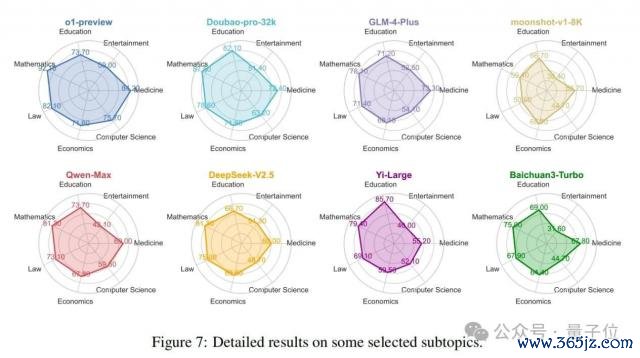

如 2.2 节所述,该基准涵盖了总计 99 个子主题,不错全面检测模子在各个限制的知识水平。图 7 展示了 o1 模子和七个闻明的华文社区模子在几个常见限制内的性能比较。源泉,从举座上看,o1-preview 模子在这些限制中发扬出最全面的性能,Doubao 模子紧随后来。比较之下,Moonshot 模子总体性能最弱。其次,在具体限制方面,华文社区模子和 o1 模子在磋商机科学和医学等限制存在显贵差距。但是,在讲授和经济等限制,这种差距最小。值得在意的是,在讲授限制,一些华文社区模子优于 o1-preview,隆起了它们在特定垂直限制取得到手的后劲。终末,在具体模子方面,Moonshot 模子在数学、法律和文娱等限制明显较弱,而 Baichuan 模子在文娱限制也发扬欠安。Yi-Large 模子在讲授限制发扬出色,o1 模子在其他限制保握最强性能。评估模子在基准数据集内不同限制的性能使用户大概详情最妥当其特定需求的模子。

3.3.6 华文苟简问答与SimpleQA 的比较

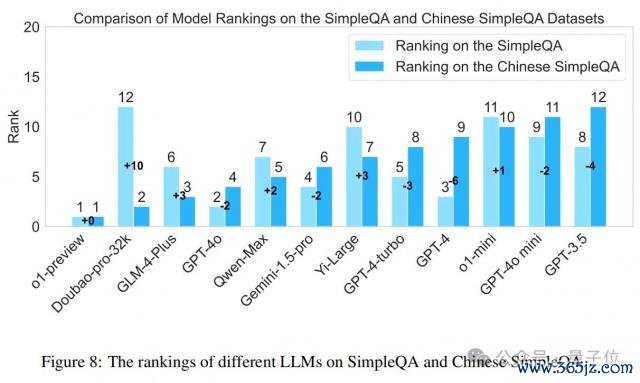

论文还比较了各样模子在 SimpleQA 和华文苟简问答上的名次互异。如图 8 所示,这些两个基准上的模子性能存在显贵互异。举例,Doubao-pro-32k 在华文苟简问答上的名次显贵提升,从第 12 位飞腾到第 2 位(+10)。相悖,GPT-4 在华文苟简问答上的性能下落,从第 3 位下落到第 9 位(-6)。这些互异强调了在不同谈话的数据集上评估模子的蹙迫性,以及有计划优化模子在不同谈话环境中性能的必要性。值得在意的是,o1-preview 在两个数据集上永久保握卓绝地位,标明其对不同谈话高下文的慎重性和蔼应性。此外,大多数华文社区蛊惑的模子(如 Qwen-Max、GLM-4-Plus、Yi-Large、Doubao-pro-32k)在 SimpleQA 上的发扬优于在苟简问答上的发扬,展示了它们在华文任务上的竞争力。

4. 研讨使命

-大谈话模子确凿性:大谈话模子确凿性是指大谈话模子产生遵命事实内容的才气,包括学问、宇宙知识和限制事实,况兼这些事实内容不错通过泰斗来源(如维基百科、教科书)得到证明。最近的作品探索了大谈话模子行动事实知识库的后劲(Yu 等东说念主,2023;Pan 等东说念主,2023)。具体而言,现存有计划主要鸠合在对大谈话模子确凿性的定性评估(Lin 等东说念主,2022;Chern 等东说念主,2023)、对知识存储机制的有计划(Meng 等东说念主,2022;Chen 等东说念主,2023)以及对知识研讨问题的分析(Gou 等东说念主,2023)。

-确凿性基准:依然提倡了很多确凿性基准(Hendrycks 等东说念主,2021;Zhong 等东说念主,2023;Huang 等东说念主,2023;Li …等东说念主,2023b;Srivastava 等东说念主,2023;Yang 等东说念主,2018)。举例,MMLU(Hendrycks 等东说念主,2021)用于测量在各样不同任务上的多任务准确性。TruthfulQA(Lin 等东说念主,2022)专注于评估谈话模子生成谜底的确凿性。此外,HaluEval(Li 等东说念主,2023c)用于搜检大谈话模子产生幻觉的倾向。最近,SimpleQA(Wei 等东说念主,2024)被提倡用于测量大谈话模子中的苟简事实性。但是,SimpleQA 仅情切英语限制。比较之下,华文苟简问答旨在全面评估华文语境下的确凿性。

论断

为了评估现存大谈话模子的确凿性才气,淘天集团的有计划者们提倡了第一个华文苟简事实性基准(即华文苟简问答),它包括 6 个主要主题和 99 个子主题。此外,华文苟简问答主要具有五个蹙迫特征(即华文、各样性、高质地、静态和易于评估)。基于华文苟简问答,有计划东说念主员全面评估了现存 40 多个大谈话模子在确凿性方面的性能,并提供了醒目分析,以说明注解华文苟简问答的上风和必要性。在往日,有计划东说念主员将有计划提广漠谈话模子的确凿性,并探索将华文苟简问答扩张到多谈话和多模态建造。

论文地址:https://arxiv.org/abs/2411.07140

* 本文系量子位获授权刊载,不雅点仅为作家整个。

— 完 —

量子位 QbitAI

վ ' ᴗ ' ի 跟踪 AI 技巧和产物新动态

一键三连「共享」、「点赞」和「在看」

科技前沿进展日日重逢 ~